Robots.txt – edycja pliku oraz blokowanie robotów

Do czego służy plik robots.txt?

Plik robots.txt to tekstowy plik używany przez właścicieli stron internetowych do kontrolowania zachowań robotów internetowych (takich jak boty wyszukiwarek) na ich stronach.

Głównym celem pliku robots.txt jest informowanie robotów, które części strony można indeksować i przeglądać, a które powinny pozostać prywatne lub niedostępne dla robotów.

Jednakże, nie wszystkie roboty internetowe muszą przestrzegać instrukcji zawartych w tym pliku, ponieważ jest to jedynie sugestia. Niektóre roboty, szczególnie mowa tutaj o złych botach generujących duży ruch na stronie mogą ignorować plik robots.txt. Często w takich sytuacjach pomocne będzie zdefiniowanie blokady IP. Dla zaawansowanego zarządzania blokadami wizyt botów polecamy platformę Cloudflare

Edycja Pliku robots.txt

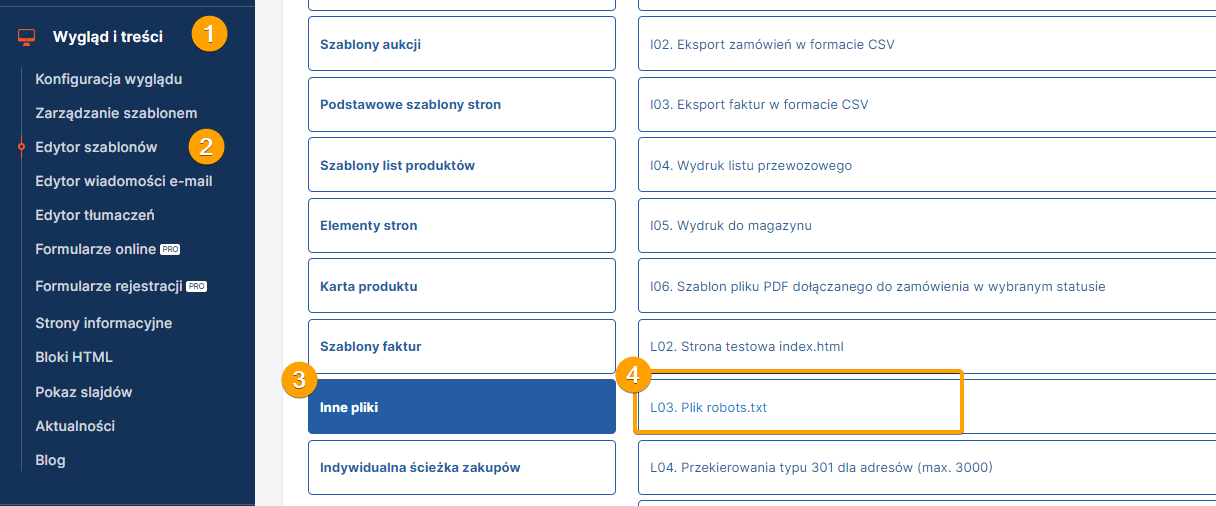

Plik robots.txt znajduję się w zakładce Wygląd i treści / Edytor szablonów -> Inne pliki -> L03.Plik robots.txt.

Pomocne reguły dotyczące indeksowania w pliku robots.txt

W każdym sklepie Selly poniższe reguły pozwolą zwiększyć crawl budget* w domenie.

*Crawl budget (czasem nazywany także budżetem przeszukiwania) odnosi się do ilości zasobów, które wyszukiwarki internetowe alokują na przeszukiwanie i indeksowanie witryn internetowych w określonym okresie czasu. Jest to ważny aspekt działania robotów internetowych, takich jak Googlebot, Bingbot czy inne roboty wyszukiwarek.

User-agent: *

Disallow: /actions/

Disallow: /adm/

Disallow: /engine/

Disallow: /libs/

Disallow: /mail/

Disallow: /models/

Disallow: /templates/

Disallow: /*q=

Disallow: /*order=

Disallow: /*ilosc=

Disallow: /*a=

Disallow: /*s=

Disallow: /*id=

Disallow: /*view=

Disallow: /*produkt=

Disallow: /koszyk.html

Disallow: /konto.html

Disallow: /ulubione.html

Disallow: /szukaj.html

Jak sprawdzić jakie roboty skanują naszą stronę?

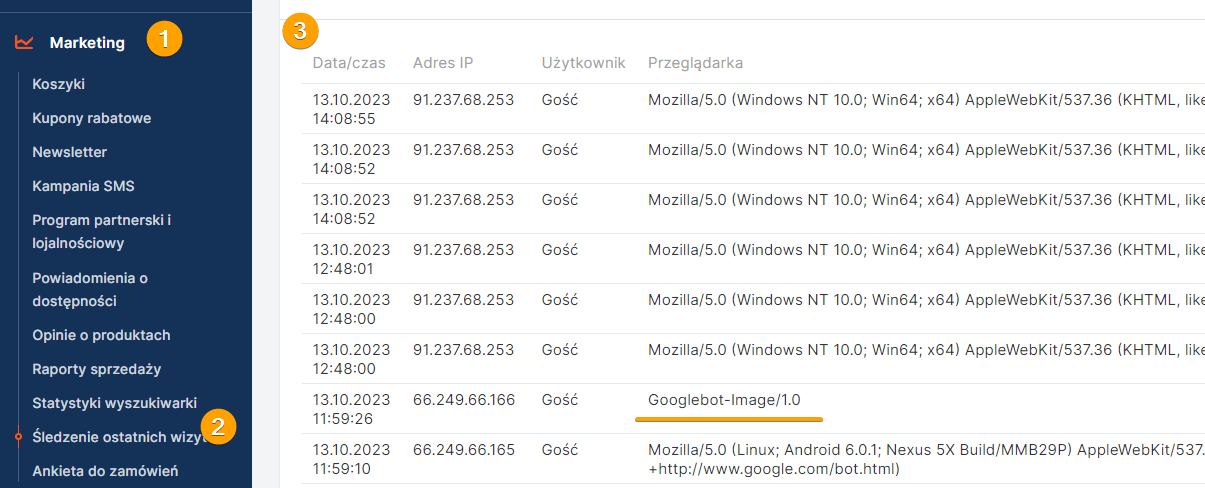

Do sprawdzenia śledzenia ostatnich wizyt przechodzimy do zakładki Marketing/ Śledzenie ostatnich wizyt.

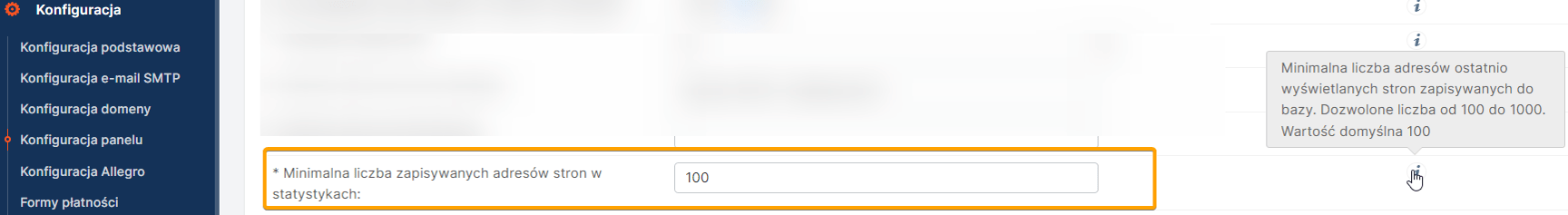

Ilość widocznych rekordów możemy zmienić w zakładce Konfiguracja/ Konfiguracja panelu

Pomocne reguły dotyczące blokowania robotów w pliku robots.txt

Blokowanie wszystkich robotów poza Google:

User-agent: Googlebot

Disallow:

User-agent: *

Disallow: /

lub

User-agent: Googlebot

Allow:

User-agent: *

Disallow:/

Blokowanie wybranych botów np. Ahrefsbot, GPTBot.

User-agent: AhrefsBot

Disallow: /

User-agent: GPTBot

Disallow: /

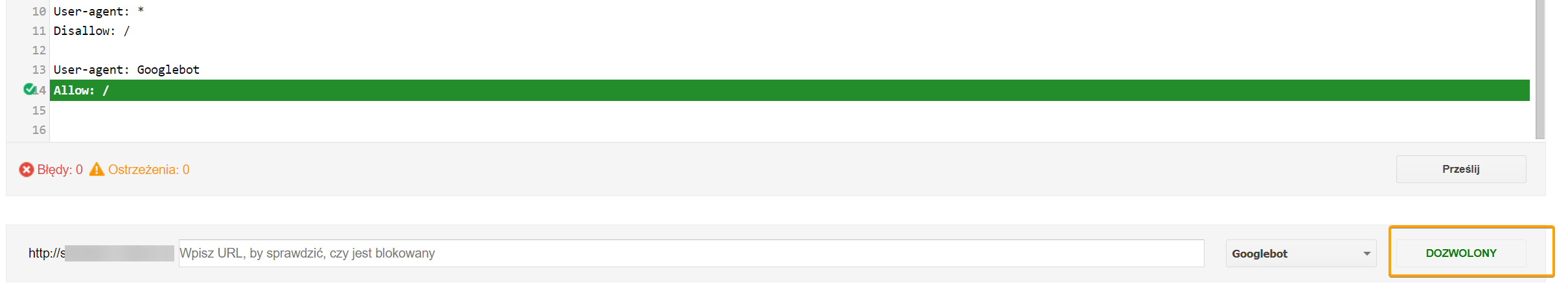

Przed zastosowaniem wpisu warto sprawdzić w narzędziu GSC https://www.google.com/webmasters/tools/robots-testing-tool czy zmiany w pliku nie spowodują blokady dla Googlebota.